IA no seu Produto: Como inovar sem descumprir a LGPD e a responsabilidade civil

- Luana Jacudi

- 6 de jan.

- 4 min de leitura

A integração de Inteligência Artificial Generativa (GenAI) deixou de ser um diferencial competitivo para se tornar uma necessidade de sobrevivência no roadmap de qualquer SaaS.

Porém, a velocidade do deploy muitas vezes atropela a análise de riscos. E não estamos falando apenas de riscos éticos abstratos, mas de riscos financeiros e operacionais imediatos.

Enquanto o Congresso debate o PL 2338/23 (Marco Legal da IA), o judiciário brasileiro já julga casos com base no Código de Defesa do Consumidor (CDC) e na LGPD. Para uma startup em escala, entender essas regras é a diferença entre um exit bem-sucedido e um passivo milionário.

1. O "Limbo" Regulatório e a Classificação de Risco

Embora o Marco Legal da IA ainda não esteja sancionado, o texto atual (inspirado no EU AI Act) traz um conceito que você já deve aplicar: a Abordagem Baseada em Risco.

O Projeto de Lei (PL) classifica sistemas de IA em "Risco Excessivo" (proibidos), "Alto Risco" e "Outros".

Sua IA é de Alto Risco? Se o seu algoritmo toma decisões que afetam a vida do usuário — como credit scoring (Fintechs), triagem de currículos (HRTechs), diagnósticos médicos (Healthtechs) ou identificação biométrica — você estará sujeito a uma governança pesada. Isso inclui relatórios de impacto, transparência algorítmica e supervisão humana obrigatória.

O Erro Comum: Achar que, por ser uma IA "criativa" ou de "suporte", ela não tem risco. Se o seu chatbot de suporte alucinar e prometer um desconto que não existe, pode ser interpretado como oferta/publicidade vinculante ou gerar dever de cumprimento/indenização, a depender do caso.

2. O Dilema dos Dados: Treinamento

Para que sua IA não seja genérica, você precisa alimentá-la com dados. Aqui entramos no terreno pantanoso da LGPD.

O Cenário: Usando dados de clientes para treinar o modelo

Você quer usar o histórico de uso dos seus clientes para melhorar o algoritmo para todos.

O Problema: Quando o cliente inseriu os dados no seu SaaS, a finalidade (Base Legal) era "execução de contrato" (usar o software). Usar esses dados para "treinar a IA" é uma nova finalidade.

A Violação: Sem um aviso claro ou uma nova base legal (como o Legítimo Interesse), isso é desvio de finalidade. A ANPD pode exigir a exclusão do modelo treinado (o que tecnicamente pode significar destruir o produto).

A Solução Técnica-Jurídica:

Anonimização na Fonte: Se o dado não tem potencial de identificar uma pessoa física, não é dado pessoal. Treine com dados anonimizados antes de entrarem na rede neural - anonimização robusta (com risco de reidentificação residual analisado).

RAG (Retrieval-Augmented Generation): Em vez de treinar o modelo com os dados, use arquitetura RAG. A IA consulta o dado em tempo real para responder, mas não "aprende" com ele permanentemente. Isso facilita o cumprimento de solicitações de exclusão de dados dos titulares.

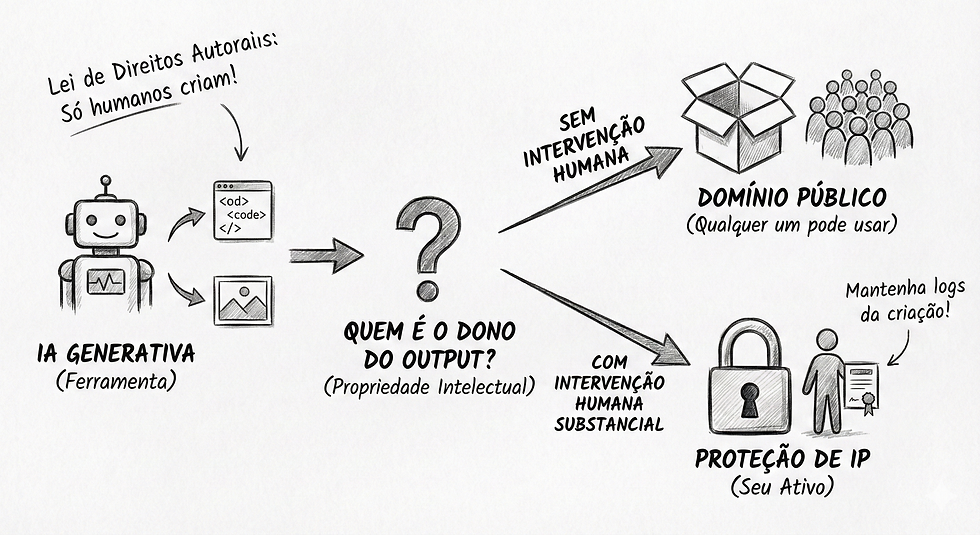

3. Propriedade Intelectual: Quem é dono do Output?

Este é o ponto cego da maioria dos contratos de desenvolvimento de software hoje.

A Lei de Direitos Autorais brasileira (Lei 9.610/98) é antropocêntrica: apenas humanos criam obras protegidas.

Código Gerado por IA: Se o seu Copilot gera 40% do código do seu software, tecnicamente, esses 40% são de domínio público. Você não tem copyright sobre eles. Com essa incerteza de que, sem contribuição humana relevante, pode não haver proteção autoral típica, é prudente: manter evidências de intervenção humana, usar cláusulas contratuais, e proteger por segredo industrial, licenças, controle de acesso, e (no caso de software) estratégias de proteção compatíveis com a Lei de Software.

Assets de Marketing: Imagens geradas por Midjourney não têm dono. Se um concorrente usar a mesma imagem, você não pode processá-lo por plágio (embora possa tentar alegar concorrência desleal).

Termos das Big Techs vs. Lei: A OpenAI diz nos termos dela que "transfere os direitos de propriedade para você". Mas atenção: um contrato privado não se sobrepõe à lei do país. Se a lei brasileira diz que não há direito autoral sem autor humano, o contrato da OpenAI não cria esse direito magicamente.

Recomendação: Mantenha logs de versionamento que provem a intervenção humana substancial no código ou na obra. O "toque humano" é o que garante a propriedade.

4. A Responsabilidade Civil: Quando a IA Alucina

Quem paga a conta quando a IA erra?

No B2C (Consumidor Final): A responsabilidade é objetiva e solidária. Se o seu app de nutrição sugerir uma dieta que causa alergia no usuário, a culpa é da sua empresa. Não adianta culpar a API do GPT. Perante o consumidor, você é o fornecedor.

No B2B (Empresas): Aqui vale o contrato. Se você fornece uma solução de IA para outra empresa, é crucial ter cláusulas de Limitação de Responsabilidade bem desenhadas.

Exemplo: Seu contrato deve deixar claro que a IA é uma ferramenta de suporte probabilístico e pode cometer erros, e que a decisão final deve ser validada por humanos. Sem essa cláusula (Human-in-the-loop), sua startup pode ser processada pelos prejuízos que uma alucinação causar ao negócio do seu cliente.

5. O Passo a Passo da Governança (AIA e LGPD)

Para escalar sem medo, implemente o Privacy by Design for AI:

AIA (Avaliação de Impacto Algorítmico): Antes de lançar a feature, documente: quais dados entram? Quais os riscos de viés? Qual a supervisão humana? Esse documento é sua defesa em caso de fiscalização.

Transparência: Avise o usuário que ele está interagindo com uma IA. O CDC impõe dever de informação e proíbe práticas enganosas, e essa é a tendência regulatória (e provável obrigação no marco de IA).

Gestão de Fornecedores: Se você usa APIs de terceiros (OpenAI, AWS Bedrock), verifique se eles usam os dados que você envia para treinar os modelos deles. Em ambientes corporativos (Enterprise), configure o "Opt-out de treinamento" nas APIs.

Conclusão: Compliance como Ferramenta de Vendas

Não encare o jurídico como um freio. No mercado B2B, grandes corporações não contratarão sua IA se você não provar que ela é segura, que não vaza dados e que a Propriedade Intelectual é garantida – ela é sua e não há terceiros envolvidos tornando o negócio mais complexo.

Ter uma governança de IA robusta não é apenas "evitar multas". É o passaporte para fechar contratos com grandes players.

Sua startup está pronta para a Era da IA ou apenas surfando o hype?

No Jacudi Advocacia, somos especialistas em adequar produtos digitais à realidade da LGPD e do Direito Digital.

Vamos construir a blindagem jurídica da sua inovação?

Comentários